Nếu bạn cảm thấy Stable Diffusion A1111 đang dùng quá chậm, thì những tùy chỉnh sau đây có thể đẩy nhanh tốc độ lên đáng kể

Dưới đây là 3 phương pháp có trong Stable Diffusion

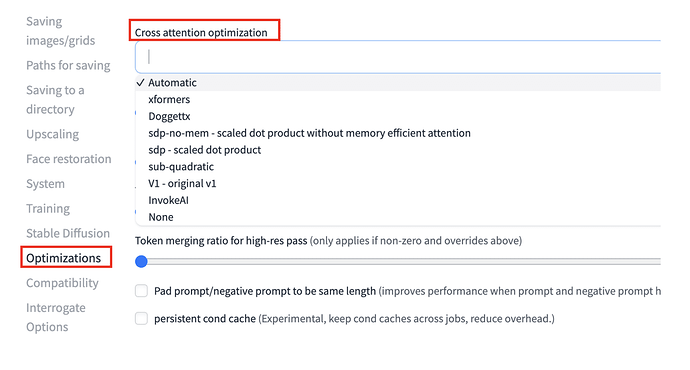

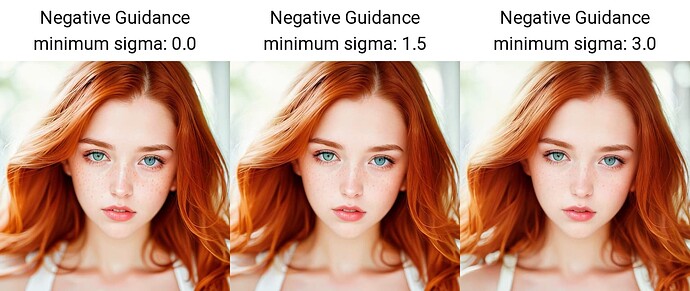

![]() Cross-attention optimization

Cross-attention optimization

Tối ưu hóa sự chú ý chéo (cross-attention) là cách mà SD sử dụng để tăng tốc, các thay đổi này làm việc tính toán nhanh hơn và tốt ít bộ nhớ hơn.

Trong phần setting, bạn có thể thấy tùy chọn này

doggettx

Trong những ngày đầu của SD, một người dùng GitHub tên Doggettx đã thực hiện một số [cải tiến về hiệu suất đối với các hoạt động chú ý chéo so với bản nguyên gốc, phương án này ít được sử dụng hiện tại

xFormers

**xFormers là thư viện máy biến áp được phát triển bởi nhóm Meta AI (lại là META) . Nó tăng tốc và giảm mức sử dụng bộ nhớ của hoạt động chú ý bằng cách triển khai[ chú ý hiệu quả về bộ nhớ và Flash Attention

Thuật toán tính toán hoạt động chú ý sử dụng ít bộ nhớ hơn với sự sắp xếp lại các bước tính toán một cách thông minh .Flash Attention tính toán thao tác chú ý từng phần nhỏ một. Kết quả cuối cùng là sử dụng ít bộ nhớ hơn và hoạt động nhanh hơn.

xFormer được coi là công nghệ tiên tiến nhất.

Scaled-Dot-Product (sdp) attention

Đây là một phương pháp cũ trước khi xFormers thay thế, nhược điểm là bạn không thể tạo 2 ảnh giống nhau hoàn toàn dù cùng thông số.

Sdp-no-mem

Chính là Sdp ở trên nhưng bỏ đi tối ưu “bộ nhớ chú ý”. Chính vì đặc điểm này nên phương pháp này cho ảnh ổn định với cùng thông số.

Sub-quadratic attention & Split-attention v1

Hai phương án thay thế cho xFormers, tuy nhiên ít được sử dụng

Invoke AI

Tối ưu hóa bằng code invoke, phù hợp cho người dùng Macbook hoặc không có tùy chọn NVIDIA

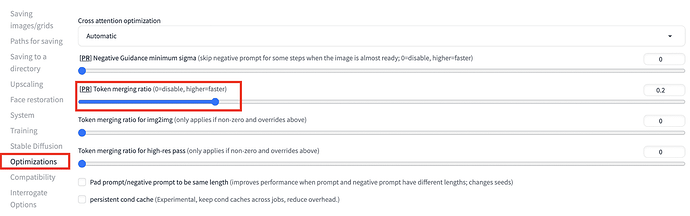

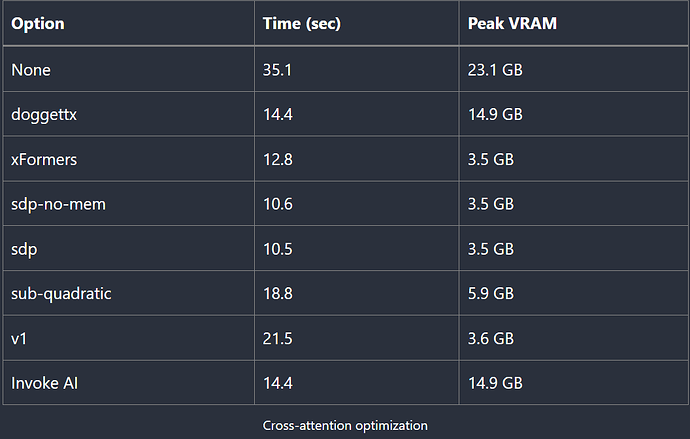

![]() Token Merging

Token Merging

Bạn có thể tìm thấy tùy chọn ở đây

Token merging (ToMe) là một kỹ thuật mới để tăng tốc độ SD bằng cách giảm số lượng mã token (trong cả prompt và negative) cần được xử lý. Phương pháp này giảm đi các token được cho là không cần thiết, từ đó tăng tốc SD

Số lượng token được hợp nhất được kiểm soát bởi tỷ lệ phần trăm token được hợp nhất.

Về token hãy đọc thêm GIỚI HẠN CỦA PROMPT

Lưu ý: Phương pháp này cũng không cho ra 2 ảnh đồng nhất nếu có cùng thông số tham chiếu.

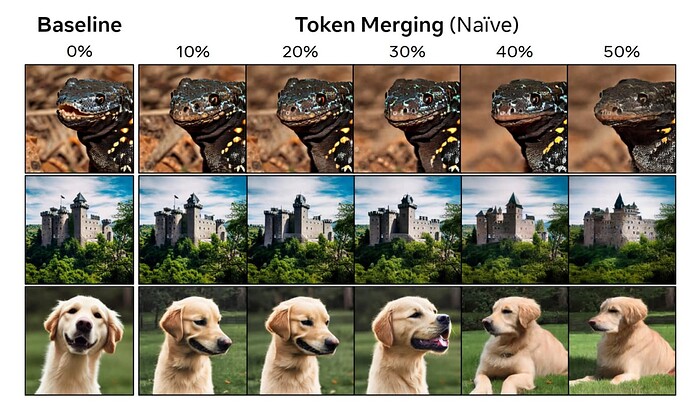

Dưới đây là một số mẫu có sự hợp nhất token từ 0% đến 50%.

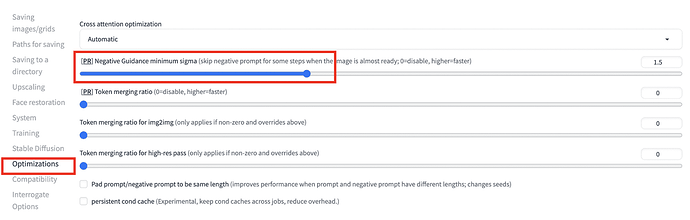

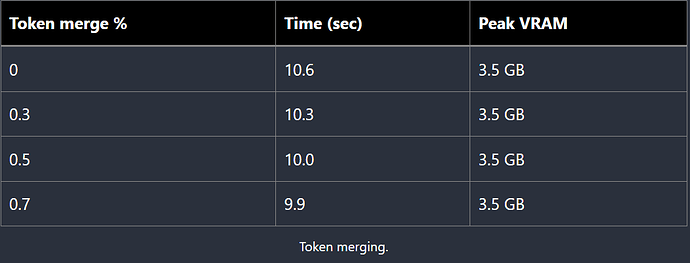

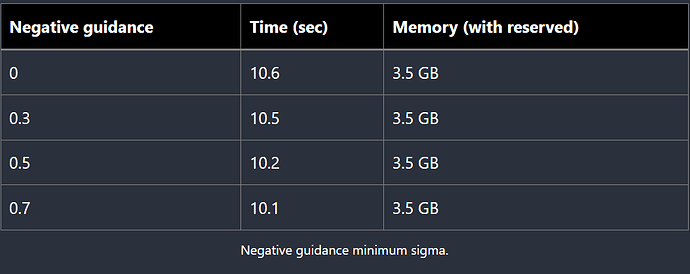

![]() Negative guidance minimum sigma (NGMS)

Negative guidance minimum sigma (NGMS)

Bạn có thể tìm thấy NGMS tại đây

Phương pháp này tắt hoặc giảm negative prompt trong một vài trường hợp được cho là không cần thiết mà không ảnh hưởng đến kết quả đầu ra.

Phương pháp này cũng tạo ra sự sai khác với các bức ảnh có cùng thông số tham chiếu.

Dưới đây là thử nghiệm tốc độ khi sử dụng các phương án do Stable Diffusion Art đưa ra.

Đối với phương pháp 1

Đối với phương pháp 2

Đối với phương pháp 3

![]() Kết luận rút ra

Kết luận rút ra

Đối với Kaikun, các cài đặt của SD đều là none và 0, tức là không sử dụng một phương án tăng tốc nào. Lý do là các server của Kaikun hiện đáp ứng tốt nhu cầu sử dụng SD của mọi người.

Đối với các bạn sử dụng khác, nếu muốn phương án tăng tốc thì nên sử dụng xFormers, vì đây là phương án mới nhất và cũng của team phát triển uy tín nhất về AI (Meta AI). Nếu vẫn chưa đủ thì có thể kết hợp thêm phương án 2 - ToMo và phương án 3 - NGMS.

Tất cả các phương án tăng tốc đều đánh đổi là chất lượng sẽ giảm đi, do đó hãy cân nhắc khi sử dụng.

Chúc mọi người thành công!