Cách sử dụng Stable Diffusion

Muốn tìm hiểu về Stable Diffusion AI?

Hướng dẫn dành cho người mới này dành cho người mới hoàn toàn chưa có kinh nghiệm với Stable Diffusion hoặc các trình tạo hình ảnh AI khác. Bạn sẽ có cái nhìn tổng quan về Stable Diffusion và một số tips cơ bản hữu ích.

Stable Diffusion là gì?

Stable Diffusion AI là một mô hình được đào tạo để tạo ra các hình ảnh AI. Những hình ảnh có thể có tính chân thực, giống như những hình ảnh được chụp bằng máy ảnh, hoặc theo phong cách nghệ thuật như được tạo ra bởi một nghệ sĩ chuyên nghiệp.

Phần tốt nhất là nó miễn phí - bạn có thể chạy nó trên máy tính cá nhân của bạn nếu máy tính bạn có cấu hình đủ mạnh. Là một phần mềm nguồn mở, Stable Diffusion cung cấp nhiều phương án tiếp cận vấn đề giúp bạn hoàn toàn tự do trong sáng tạo.

Cách sử dụng Stable Diffusion?

Bạn cần cung cấp một yêu cầu mô tả hình ảnh. Ví dụ:

prompt: gingerbread house, diorama, in focus, white background, toast , crunch cereal

Stable Diffusion sẽ biến yêu cầu này thành các hình ảnh giống như những hình ảnh dưới đây.

Bạn có thể tạo ra bất kỳ biến thể nào bạn muốn từ cùng một yêu cầu.

Tại sao nên chọn Stable Diffusion?

Các ưu điểm của Stable Diffusion AI bao gồm:

Mã nguồn mở: Rất nhiều người đam mê đã tạo ra các công cụ và mô hình miễn phí.

Khả năng xử lý: Stablediffusion làm được rất nhiều trong việc tạo ảnh, video, giới hạn chỉ là trí tưởng tượng của bạn

Cập nhật: Luôn luôn được cập nhật và đổi mới, nếu muốn có một tính năng gì đó bạn luôn có thể yêu cầu trên cộng đồng và sẽ có người tạo ra giúp bạn.

Stable Diffusion AI có miễn phí không?

Stable Diffusion là miễn phí khi bạn chạy trên máy tính cá nhân của bạn có hệ điều hành Windows hoặc Mac. Dịch vụ trực tuyến có thể sẽ tốn một khoản phí nhỏ vì có người cung cấp phần cứng để bạn chạy.

Stable Diffusion có thể làm gì?

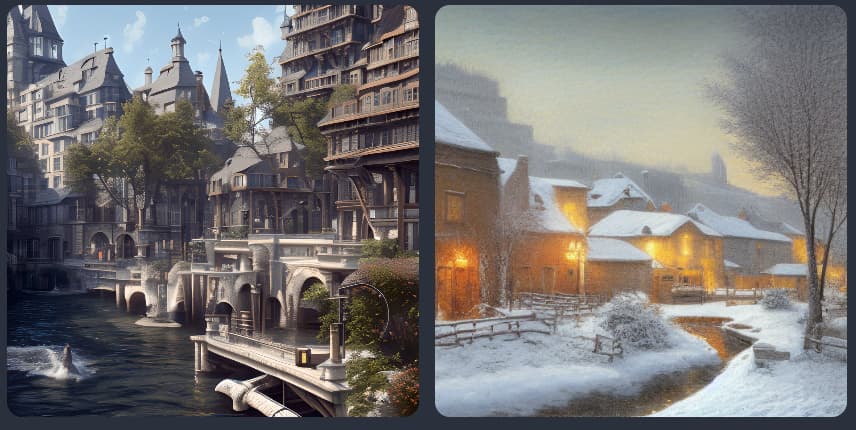

1. Tạo hình ảnh từ văn bản

Sử dụng cơ bản nhất của Stable Diffusion là chuyển đổi văn bản thành hình ảnh (txt2img). Dưới đây là một số ví dụ về các hình ảnh bạn có thể tạo ra bằng Stable Diffusion.*

Anime style

Photorealistic style

Landscape

Fantasy

Artistic style

Animals

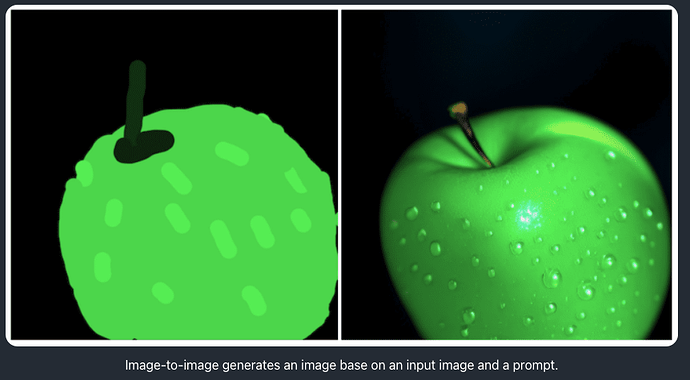

2. Tạo hình ảnh từ một hình ảnh khác

Chức năng chuyển đổi hình ảnh thành hình ảnh (img2img) biến đổi một hình ảnh thành một hình ảnh khác bằng cách sử dụng Stable Diffusion AI.

Dưới đây là một ví dụ về việc biến đổi bức vẽ của tôi về một quả táo thành một hình ảnh có tính chân thực như ảnh.

3. Chỉnh sửa ảnh

Bạn có thể sử dụng chức năng inpainting để tái tạo một phần của hình ảnh AI hoặc thực tế. Điều này tương tự như chức năng generative fill mới của Photoshop, nhưng miễn phí.

4. Tạo video

Có hai cách chính để tạo video bằng Stable Diffusion: (1) từ một yêu cầu văn bản và (2) từ một video khác.

AnimateDiff là một cách phổ biến để tạo video từ Stable Diffusion. AnimateDiff được ưa chuộng vì sáng tạo và sự đa dạng trong các mô hình được đào tạo.

Làm thế nào để sử dụng Stable Diffusion AI?

Trình tạo trực tuyến

Đối với người mới hoàn toàn, chúng tôi khuyến nghị bạn sử dụng một hệ thống online. Lợi ích của hệ thống này các công cụ đã được cài đặt sẵn và kiểm tra các sai sót. Các hệ thống online nổi tiếng đang chạy SD bao gồm google colab và Kaikun Ai.

Mặt hạn chế của các trình tạo trực tuyến là hệ thống sẽ hoạt động chậm và phụ thuộc nhiều vào chất lượng internet của bạn

Giao diện người dùng đồ họa (GPU) nâng cao

Nếu bạn tự tin vào cấu hình của máy tính của mình, và sử dụng SD một thời gian, bạn có thể tự cài Stable Diffusion và sử dụng theo yêu cầu của bạn mà không phụ thuộc vào các yếu tố bên ngoài khác.

Làm thế nào để tạo một yêu cầu tốt?

Có rất nhiều điều cần học để tạo ra một prompt đủ tốt. Nhưng cơ bản là mô tả chủ đề của bạn càng chi tiết càng tốt. Hãy đảm bảo bao gồm các từ khóa (keywords) mạnh để xác định phong cách.

Sử dụng một trình tạo yêu cầu là một cách tốt để học quá trình từng bước và từ khóa quan trọng. Điều quan trọng cho người mới bắt đầu là học một tập hợp các từ khóa mạnh và tác động dự kiến của chúng. Điều này giống như việc học từ vựng cho một ngôn ngữ mới. Bạn cũng có thể tìm thấy một danh sách ngắn các từ khóa và ghi chú tại đây.

Một cách để tạo ra các hình ảnh chất lượng cao một cách nhanh chóng là sử dụng lại các prompt hiện có. Đi tới một nơi sưu tầm prompt, chọn một hình ảnh bạn thích và “copy” prompt! Nhược điểm là bạn có thể không hiểu tại sao nó tạo ra các hình ảnh chất lượng cao. Đọc các ghi chú và thay đổi yêu cầu để xem hiệu ứng.

Hoặc, sử dụng các trang web thu thập hình ảnh như PlaygroundAI. Chọn một hình ảnh bạn thích và chỉnh sửa lại yêu cầu.

Một số quy tắc cơ bản để xây dựng các prompt tốt

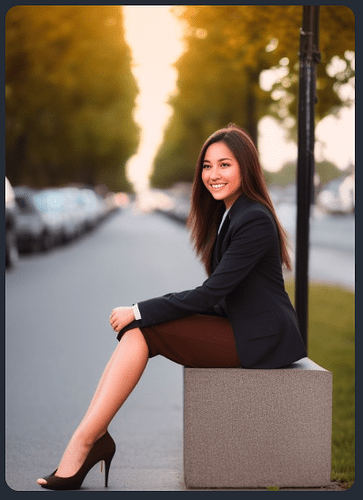

Hãy chi tiết và cụ thể

Mặc dù trí tuệ nhân tạo tiến bộ nhưng Stable Diffusion vẫn không thể đọc được suy nghĩ của bạn. Bạn cần mô tả hình ảnh của mình càng chi tiết càng tốt.

Hãy tưởng tượng bạn muốn tạo ra một hình ảnh của một người phụ nữ trong một cảnh phố. Một yêu cầu đơn giản

a woman on street

sẽ cho bạn một hình ảnh như sau:

Có lẽ bạn không muốn tạo ra hình ảnh của bà già, nhưng yêu cầu của bạn kỹ thuật cũng phù hợp. Bạn không thể trách Stable Diffusion…

Thay vào đó, bạn nên viết chi tiết hơn.

a young lady, brown eyes, highlights in hair, smile, wearing stylish business casual attire, sitting outside, quiet city street, rim lighting

Nhìn vào sự khác biệt đáng kể này. Vì vậy, hãy nâng cao kỹ năng viết prompt của bạn!

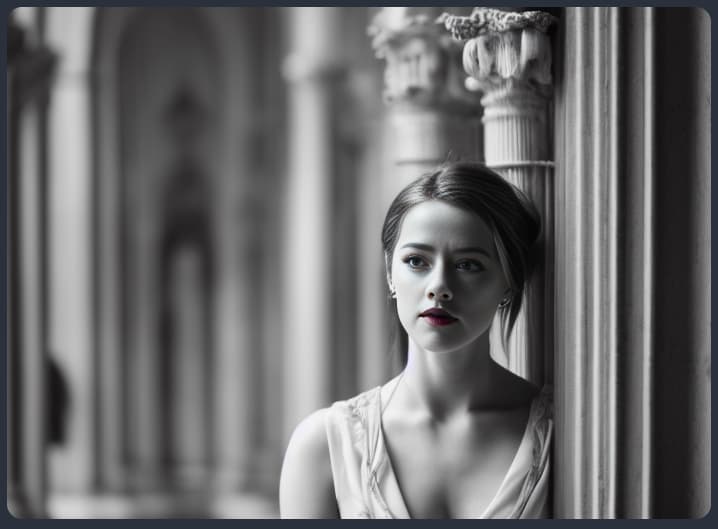

Sử dụng từ khóa mạnh mẽ

Một số từ khóa mạnh mẽ hơn các từ khóa khác. Ví dụ bao gồm

Tên người nổi tiếng (ví dụ: Emma Watson)

Tên nghệ sĩ (ví dụ: van Gogh)

Phương tiện nghệ thuật (ví dụ: illustration, painting, photograph)

Sử dụng chúng một cách cẩn thận có thể định hướng hình ảnh theo hướng bạn muốn.

Bạn có thể tìm hiểu thêm về việc xây dựng yêu cầu và các từ khóa ví dụ trong cơ bản về xây dựng yêu cầu.

Muốn “cheat”? Giống như làm bài tập về nhà, bạn có thể sử dụng ChatGPT để tạo prompt!

Những thông số đó là gì và tôi có nên thay đổi chúng không?

Hầu hết các trình tạo trực tuyến cho phép bạn thay đổi một tập hợp hạn chế các thông số. Dưới đây là một số thông số quan trọng:

Image size : Kích thước của hình ảnh đầu ra. Kích thước tiêu chuẩn là 512x512 pixel. Thay đổi nó thành kích thước dọc hoặc ngang có thể ảnh hưởng lớn đến hình ảnh. Ví dụ, sử dụng kích thước dọc để tạo ra hình ảnh toàn thân.

Sampling steps : Sử dụng ít nhất 20 bước. Tăng nếu bạn thấy hình ảnh mờ.

CFG scale: Giá trị thông thường là 7. Tăng nếu bạn muốn hình ảnh tuân theo yêu cầu hơn.

Seed value: -1 tạo ra một hình ảnh ngẫu nhiên. Chỉ định một giá trị nếu bạn muốn có cùng một hình ảnh.

Xem các khuyến nghị khác xin hãy tiếp tục đọc những bài tiếp theo của FROM ZERO TO HERO

Bạn nên luôn tạo ra nhiều hình ảnh khi generate một prompt.

Tôi tạo ra 2-4 hình ảnh cùng một lúc khi thay đổi lớn cho yêu cầu để tôi có thể tăng tốc quá trình tìm kiếm. Tôi sẽ tạo ra 4 hình ảnh cùng một lúc khi thay đổi nhỏ để tăng cơ hội thấy được một cái gì đó có thể sử dụng.

Một số yêu cầu chỉ hoạt động được một nửa thời gian hoặc ít hơn. Vì vậy, đừng loại trừ một yêu cầu dựa trên một hình ảnh.

Cách thông thường để sửa các khuyết điểm trong hình ảnh

Khi bạn thấy các hình ảnh AI đẹp mắt được chia sẻ trên mạng xã hội, có khả năng lớn chúng đã trải qua một loạt các bước xử lý sau sản xuất. Chúng tôi sẽ trình bày một số trong số chúng trong phần này.

Face Restoration

Nói chung trong cộng đồng nghệ sĩ trí tuệ nhân tạo, có thông tin rằng Stable Diffusion không tốt trong việc tạo ra các khuôn mặt. Rất thường xuyên, các khuôn mặt được tạo ra có artifacts.

Chúng thường sử dụng các mô hình trí tuệ nhân tạo hình ảnh được đào tạo để phục hồi khuôn mặt, ví dụ như CodeFormer, mà AUTOMATIC1111 GUI đã tích hợp sẵn. Xem cách bật nó.

Bạn có biết rằng có bản cập nhật cho các mô hình v1.4 và v1.5 để sửa chữa vấn đề về mắt không? Xem cách cài đặt VAE.

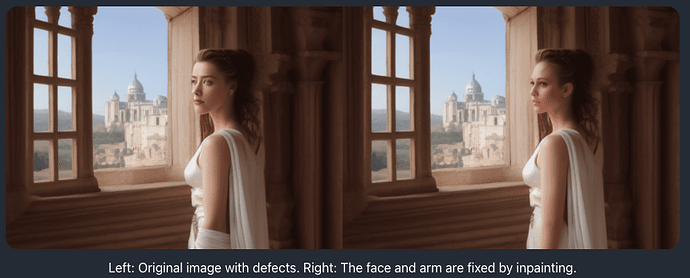

Sửa chữa các hiện tượng nhỏ bằng cách sử dụng inpainting

Việc có được hình ảnh bạn muốn trong lần thử đầu tiên thường khó khăn. Một cách tiếp cận tốt hơn là tạo ra một hình ảnh với cấu trúc tốt. Sau đó, sửa chữa các khuyết điểm bằng cách sử dụng inpainting.

Dưới đây là một ví dụ về một hình ảnh trước và sau khi sử dụng kỹ thuật inpainting. Sử dụng yêu cầu ban đầu cho inpainting hoạt động 90% thời gian.

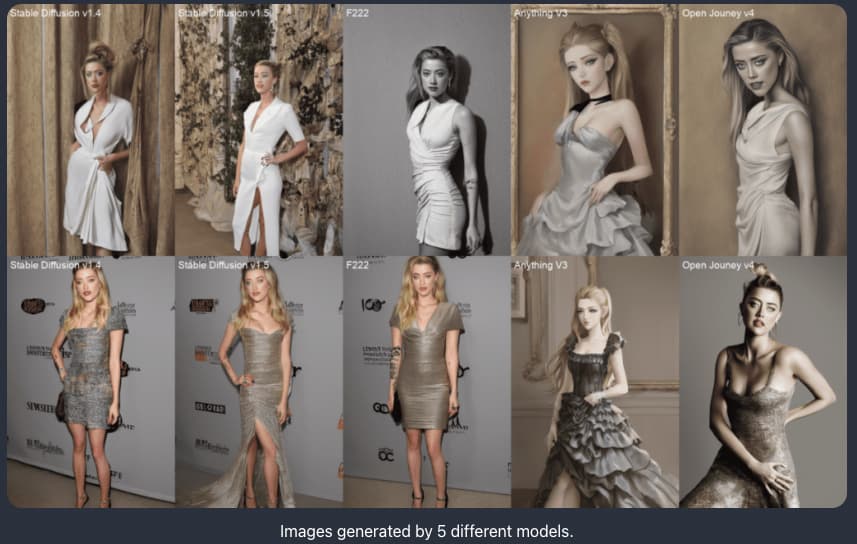

Các model tùy chỉnh là gì?

Các model gốc được phát hành bởi Stability AI và các đối tác của họ được gọi là các model cơ bản. Một số ví dụ về các mô hình cơ bản là Stable Diffusion 1.4, 1.5, 2.0 và 2.1.

Các model tùy chỉnh được đào tạo từ các model cơ bản. Hiện nay, hầu hết các model đều được đào tạo từ v1.4 hoặc v1.5. Chúng được đào tạo với dữ liệu bổ sung để tạo ra hình ảnh theo các phong cách hoặc đối tượng cụ thể.

Chỉ mình bầu trời là giới hạn khi đến với các model tùy chỉnh. Nó có thể là phong cách anime, phong cách Disney hoặc phong cách của một trí tuệ nhân tạo khác. Bạn nói lên điều đó.

Dưới đây là một so sánh của 5 model khác nhau.

Model nào tôi nên sử dụng?

Hãy bắt đầu với các model gốc nếu bạn đang bắt đầu. Có rất nhiều thứ để học và thử nghiệm để giữ bạn bận rộn trong suốt vài tháng.

Ba phiên bản chính của Stable Diffusion là v1, v2 và Stable Diffusion XL (SDXL).

Các model v1 là 1.4 và 1.5.

Các model v2 là 2.0 và 2.1.

SDXL 1.0

Bạn có thể nghĩ rằng bạn nên bắt đầu bằng các model v2 mới hơn. Mọi người vẫn đang cố gắng tìm hiểu cách sử dụng các model v2. Hình ảnh từ v2 không nhất thiết phải tốt hơn so với v1.

Có loạt mô hình SDXL được phát hành: SDXL beta, SDXL 0.9 và phiên bản mới nhất là SDXL 1.0.

Tôi khuyên bạn nên sử dụng các model v1.5 và SDXL 1.0 nếu bạn mới sử dụng Stable Diffusion.

Làm cách nào để đào tạo một model mới?

Một ưu điểm của việc sử dụng Stable Diffusion là bạn có hoàn toàn quyền kiểm soát model. Bạn có thể tạo ra một model riêng của bạn với phong cách độc đáo nếu bạn muốn. Có hai cách chính để đào tạo mô hình: (1) Dreambooth và (2) embedding.

Dreambooth được coi là mạnh mẽ hơn vì nó điều chỉnh mức trọng lượng của toàn bộ mô hình. Nhúng để mô hình không bị ảnh hưởng nhưng tìm các từ khóa để mô tả chủ đề hoặc phong cách mới.

Bạn có thể thử nghiệm với sổ tay Colab trong bài viết về dreambooth.

Negative Prompts

Bạn đặt những gì bạn muốn thấy trong prompt. Bạn đặt những gì bạn không muốn thấy trong Negative Prompts. Không phải tất cả các dịch vụ Stable Diffusion đều hỗ trợ Negative Prompts. Nhưng nó rất hữu ích cho các mô hình v1 và là bắt buộc đối với các mô hình v2. Đối với người mới bắt đầu, việc sử dụng Negative Prompts tổng quan cũng không gây hại. Đọc thêm về Negative Prompts:

Làm thế nào Negative Prompts hoạt động?

Cách sử dụng Negative Prompts là gì?

Làm thế nào để làm ảnh lớn với Stable Diffusion?

Độ phân giải gốc của Stable Diffusion là 512×512 pixel cho các mô hình v1. Bạn KHÔNG NÊN tạo ra các hình ảnh với chiều rộng và chiều cao khác nhau quá nhiều so với 512 pixel. Sử dụng các cài đặt kích thước sau để tạo ra hình ảnh ban đầu.

Hình ảnh ngang: Đặt chiều cao là 512 pixel. Đặt chiều rộng cao hơn, ví dụ 768 pixel (tỷ lệ 2:3)

Hình ảnh dọc: Đặt chiều rộng là 512 pixel. Đặt chiều cao cao hơn, ví dụ 768 pixel (tỷ lệ 3:2)

Nếu bạn đặt chiều rộng và chiều cao ban đầu quá cao, bạn sẽ thấy những chủ đề trùng lặp.

Bước tiếp theo là nâng cấp hình ảnh. Giao diện người dùng AUTOMATIC1111 miễn phí đi kèm với một số công cụ nâng cấp AI phổ biến.

Làm thế nào để kiểm soát cấu trúc hình ảnh?

Công nghệ Stable Diffusion đang phát triển nhanh chóng. Có một số cách để kiểm soát nó.

Image-to-image

Bạn có thể yêu cầu Stable Diffusion tuân theo một cách đại khái một hình ảnh đầu vào khi tạo ra một hình ảnh mới. Đó gọi là Image-to-image. Dưới đây là một ví dụ về việc sử dụng một hình ảnh đầu vào của một con đại bàng để tạo ra một con rồng. Cấu trúc của hình ảnh đầu ra tuân theo hình ảnh đầu vào.

ControlNet

ControlNet cũng sử dụng một hình ảnh đầu vào để chỉ đạo đầu ra. Nhưng nó có thể trích xuất thông tin cụ thể, ví dụ như tư thế của con người. Dưới đây là một ví dụ về việc sử dụng ControlNet để sao chép một tư thế con người từ hình ảnh đầu vào.

Ngoài tư thế của con người, ControlNet còn có thể trích xuất thông tin khác, chẳng hạn như đường nét.

Regional prompting

Bạn có thể chỉ định gợi ý cho một số phần cụ thể của hình ảnh bằng cách sử dụng một phần mở rộng gọi là Regional Prompter. Kỹ thuật này rất hữu ích để vẽ các đối tượng chỉ trong một số phần cụ thể của hình ảnh.

Dưới đây là một ví dụ về việc đặt một con sói ở góc dưới bên trái và hình đầu lâu ở góc dưới bên phải.

Chuyển đổi độ sâu thành hình ảnh

Chuyển đổi độ sâu thành hình ảnh là một cách khác để kiểm soát sự sắp đặt thông qua một hình ảnh đầu vào. Nó có thể phát hiện phần trước cảnh và phần nền của hình ảnh đầu vào. Hình ảnh đầu ra sẽ tuân theo cùng phần trước cảnh và phần nền. Dưới đây là một ví dụ.

Bước tiếp theo

Vậy bạn đã hoàn thành nhập môn đầu tiên From Zero to Hero, hãy tiếp tục theo dõi chúng tôi trong serie sắp tới.

Bài viết có sự tham khảo từ từ stable-diffusion-art.com