Trong một bản cập nhật chưa được thông báo về chính sách sử dụng, OpenAI đã mở cửa cho việc ứng dụng công nghệ của họ vào mục đích quân sự. Trong khi chính sách trước đây cấm sử dụng sản phẩm của họ cho mục đích “quân sự và chiến tranh,” thì ngôn từ đó nay đã biến mất, và OpenAI không phủ nhận rằng họ giờ đây mở cửa cho việc sử dụng quân sự.

The Intercept là người đầu tiên nhận thấy sự thay đổi, dường như đã được thực hiện vào ngày 10 tháng 1.

Những thay đổi không được thông báo về từ ngữ chính sách xảy ra khá thường xuyên trong ngành công nghệ khi sản phẩm mà họ quản lý thay đổi và phát triển, và OpenAI rõ ràng không phải là ngoại lệ. Thực tế, thông báo gần đây của công ty về việc triển khai công cụ GPT tùy chỉnh cho người dùng cùng với chính sách kiếm tiền mơ hồ có lẽ đã đòi hỏi một số thay đổi.

Nhưng sự thay đổi chính sách không quân sự khó có thể là hậu quả của sản phẩm mới này. Cũng không thể tin được rằng việc loại bỏ “quân sự và chiến tranh” chỉ là “rõ ràng hơn” hoặc “dễ đọc hơn,” như phát ngôn của OpenAI về bản cập nhật. Đó là sự thay đổi chính sách có tính chất quan trọng, không phải chỉ là tái phát biểu chính sách cũ.

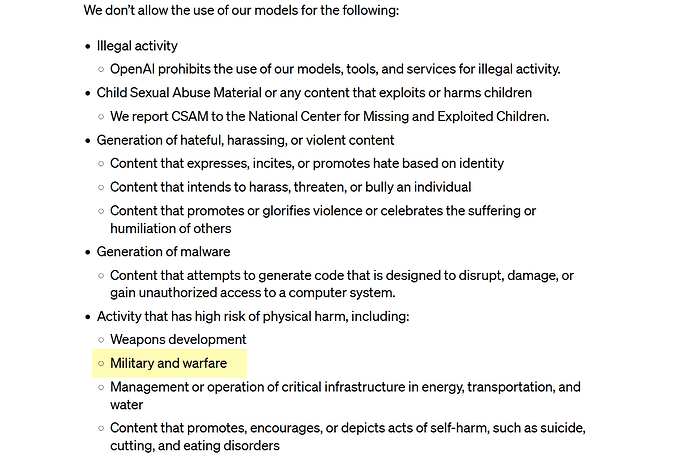

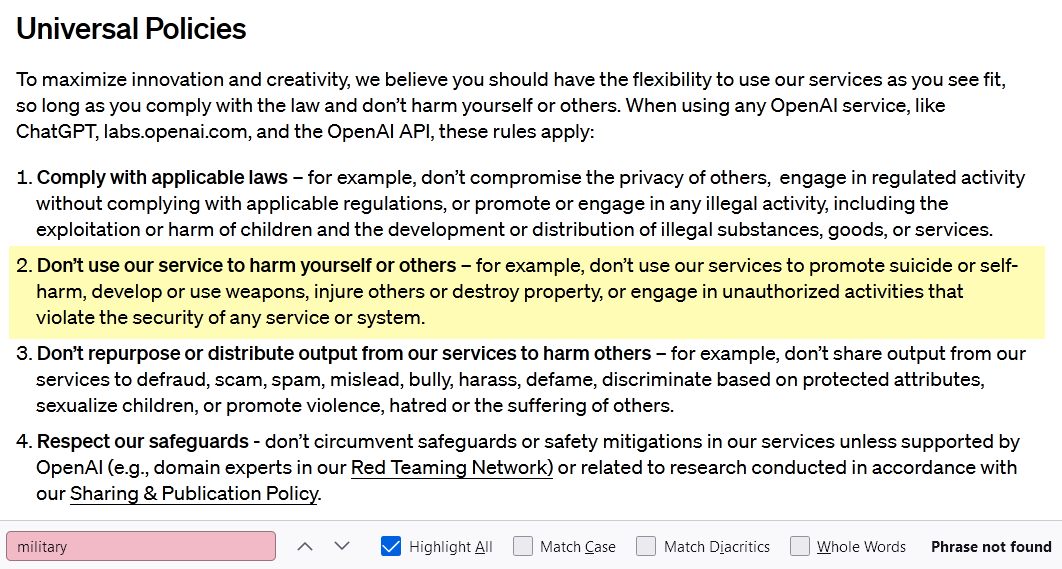

Bạn có thể đọc chính sách sử dụng hiện tại ở đây, và chính sách cũ ở đây. Dưới đây là các ảnh chụp màn hình với các phần liên quan được làm nổi bật:

Rõ ràng toàn bộ văn bản đã được viết lại, dù có dễ đọc hơn hay không thì còn tùy thuộc vào sở thích cá nhân. Tôi nghĩ rằng một danh sách gạch đầu dòng về các hành vi cấm cụ thể sẽ dễ đọc hơn so với các hướng dẫn chung chung mà nó đã được thay thế. Nhưng các nhà soạn thảo chính sách tại OpenAI rõ ràng có quan điểm khác, và nếu điều này mang lại cho họ nhiều lựa chọn hơn để giải thích thuận lợi hoặc không thuận lợi cho một thực hành trước đây bị cấm ngay lập tức, thì đó chỉ là một hậu quả đáng mừng. “Đừng làm hại người khác,” công ty tuyên bố, “rộng lớn nhưng dễ hiểu và liên quan trong nhiều bối cảnh.” Linh hoạt hơn nữa.

Mặc dù, như đại diện của OpenAI, Niko Felix, giải thích, vẫn còn một lệnh cấm toàn diện đối với việc phát triển và sử dụng vũ khí - bạn có thể thấy rằng nó ban đầu được liệt kê riêng biệt từ “quân sự và chiến tranh.” Dù sao, quân đội cũng làm nhiều việc hơn là sản xuất vũ khí, và vũ khí cũng được sản xuất bởi những người khác không phải quân đội.

Và chính xác là ở những nơi mà hai lĩnh vực này không chồng chéo, tôi đoán rằng OpenAI đang xem xét những cơ hội kinh doanh mới. Không phải mọi thứ mà Bộ Quốc phòng làm đều liên quan trực tiếp đến chiến tranh; như bất kỳ học giả, kỹ sư hoặc chính trị gia nào cũng biết, cơ sở quân sự tham gia sâu rộng vào nhiều loại nghiên cứu cơ bản, đầu tư, quỹ doanh nghiệp nhỏ và hỗ trợ cơ sở hạ tầng.

Các nền tảng GPT của OpenAI có thể rất hữu ích cho, chẳng hạn, các kỹ sư quân đội muốn tổng kết hàng thập kỷ tài liệu về cơ sở hạ tầng nước của một khu vực. Đối với nhiều công ty, việc định nghĩa và điều hướng mối quan hệ của họ với nguồn tiền chính phủ và quân đội là một bài toán khó. “Dự án Maven” của Google nổi tiếng đã đi quá xa, mặc dù ít người dường như bị làm phiền bởi hợp đồng đám mây JEDI trị giá hàng tỷ đô la. Có thể chấp nhận được cho một nhà nghiên cứu học thuật với khoản tài trợ từ phòng thí nghiệm Nghiên cứu Không quân sử dụng GPT-4, nhưng không phải cho một nhà nghiên cứu bên trong AFRL làm việc cùng dự án đó. Bạn sẽ vẽ ranh giới ở đâu? Ngay cả một chính sách “không quân sự” nghiêm ngặt cũng phải dừng lại sau một vài bước.

Nói như vậy, việc loại bỏ hoàn toàn “quân sự và chiến tranh” khỏi những mục cấm sử dụng của OpenAI cho thấy, ít nhất, công ty này sẵn lòng phục vụ khách hàng quân sự. Tôi đã yêu cầu công ty xác nhận hoặc phủ nhận điều này, cảnh báo họ rằng ngôn từ của chính sách mới làm rõ rằng bất kỳ điều gì ngoài phủ nhận sẽ được hiểu là một sự xác nhận.

cre: techcrunch