Dưới đây là câu trả lời được viết bởi con người về cách ChatGPT hoạt động.

ChatGPT mới trở thành tên tuổi phổ biến trong chưa đầy một năm, nhưng các thuật toán đang hoạt động trong nền của công cụ AI phổ biến này thực sự đã cung cấp cho một loạt các ứng dụng và dịch vụ kể từ năm 2020. Vì vậy, để hiểu cách ChatGPT hoạt động, chúng ta cần bắt đầu bằng việc nói về sức mạnh ngôn ngữ đứng sau nó.

GPT trong ChatGPT chủ yếu là hai thuật toán liên quan: GPT-3.5 Turbo và GPT-4, mặc dù phiên bản GPT-4 chỉ có sẵn trong ChatGPT dành cho người đăng ký ChatGPT Plus. GPT là viết tắt của Generative Pre-trained Transformer, và số đằng sau là phiên bản của thuật toán. Các mô hình GPT được phát triển bởi OpenAI (công ty đứng sau ChatGPT và trình tạo hình DALL·E), nhưng chúng cung cấp cho mọi thứ từ các tính năng AI của Bing đến các công cụ viết như Jasper hay Copy.ai. Thực tế, hầu hết các trình tạo văn bản AI hiện có đều sử dụng GPT-3, GPT-3.5 và GPT-4 - mặc dù chúng thường không tiết lộ nó được sử dụng bởi phiên bản nào.

ChatGPT mang GPT đến tầm cao mới vì nó đã đơn giản hóa quá trình tương tác với trình tạo văn bản AI và - quan trọng nhất - miễn phí cho mọi người. Hơn nữa, đó là một chatbot, và mọi người luôn yêu thích một chatbot hay từ thời SmarterChild.

Mặc dù GPT-3.5 và GPT-4 hiện là các mô hình ngôn ngữ lớn (LLMs) phổ biến nhất hiện nay, trong vài năm tới, có lẽ sẽ có nhiều sự cạnh tranh hơn. Ví dụ, Google có Bard - chatbot AI của mình, được cung cấp bởi động cơ ngôn ngữ riêng của nó, Pathways Language Model (PaLM 2). Meta, công ty mẹ của Facebook, đã phát hành Llama 2, LLM mới nhất của mình. Và sau đó là các lựa chọn khác dành cho các công ty lớn, như Writer’s Palmyra LLMs và Anthropic’s Claude. Tuy nhiên, ít nhất là hiện tại, sản phẩm của OpenAI là tiêu chuẩn ngành công nghiệp LLMs. Đó chỉ đơn giản là công cụ dễ dàng nhất để mọi người tiếp cận.

Vậy câu trả lời cho “ChatGPT hoạt động như thế nào?” chủ yếu là: GPT-3.5 và GPT-4. Nhưng hãy cùng tìm hiểu sâu hơn nữa qua nội dung dưới.

ChatGPT là gì?

ChatGPT là một ứng dụng được xây dựng bởi OpenAI. Sử dụng các mô hình ngôn ngữ GPT, nó có thể trả lời câu hỏi của bạn, viết bản sao, soạn thảo email, trò chuyện, giải thích mã nguồn trong các ngôn ngữ lập trình khác nhau, dịch ngôn ngữ tự nhiên code, và nhiều chức năng khác - hoặc ít nhất là cố gắng trả lời - tất cả dựa trên các lệnh ngôn ngữ tự nhiên bạn cung cấp. Đó là một chatbot, nhưng một chatbot thực sự, thực sự rất tốt.

Dù thật thú vị khi chơi với nó, ví dụ như nếu bạn muốn viết một bài thơ theo phong cách Shakespeare về thú cưng của mình hoặc tìm kiếm một số ý tưởng cho dòng chủ đề cho một số email tiếp thị, nó cũng rất hữu ích bởi công nghệ của OpenAI. Đó là cách thu thập rất nhiều dữ liệu từ người dùng thực và phục vụ như một phiên bản demo hoành tráng với sức mạnh của GPT, mà nếu không có thì có thể cảm thấy hơi mơ hồ trừ khi bạn hiểu sâu vào lĩnh vực học máy. (Việc thu thập dữ liệu này đã khiến ChatGPT bị chặn ở Italy vào đầu năm 2023, tuy nhiên mối quan ngại của các nhà quản lý Ý giờ đây đã được giải quyết.)

Hiện tại, ChatGPT cung cấp hai mô hình GPT. Mặc định, GPT-3.5, ít mạnh mẽ hơn nhưng miễn phí cho mọi người. GPT-4 tiên tiến hơn chỉ giới hạn cho người đăng ký ChatGPT Plus nhưng đang giới hạn số câu hỏi trong ngày với GPT-4. (Hiện tại là 50 tin nhắn mỗi ba giờ, nhưng điều này có thể thay đổi trong tương lai.)

Một trong những tính năng lớn của ChatGPT là nó có thể nhớ cuộc trò chuyện bạn đang có với nó. Điều này có nghĩa là nó có thể hiểu được ngữ cảnh từ những gì bạn đã hỏi trước đó và sau đó sử dụng thông tin đó để trò chuyện với bạn. Bạn cũng có thể yêu cầu chỉnh sửa và sửa chữa, và nó sẽ tham chiếu lại những gì bạn đã thảo luận trước đó. Điều này khiến việc tương tác với AI cảm giác như một cuộc trò chuyện thực sự.

Nếu bạn muốn thực sự cảm nhận được nó, hãy dành năm phút để chơi với ChatGPT ngay bây giờ (nó miễn phí!) và sau đó trở lại để đọc về cách nó hoạt động.

ChatGPT hoạt động như thế nào?

Bộ dữ liệu khổng lồ này đã được sử dụng để tạo nên một mạng nơ-ron học sâu […] mô phỏng theo bộ não con người - điều này cho phép ChatGPT học được các mẫu và mối quan hệ trong dữ liệu văn bản […] dự đoán văn bản tiếp theo trong bất kỳ câu từ nào.

ChatGPT hoạt động bằng cách cố gắng hiểu yêu cầu của bạn và sau đó phát ra chuỗi các từ mà nó dự đoán sẽ trả lời tốt nhất cho câu hỏi của bạn, dựa trên dữ liệu mà nó đã được huấn luyện. Mặc dù điều đó có vẻ tương đối đơn giản, nhưng nó che dấu sự phức tạp của những gì đang diễn ra bên dưới.

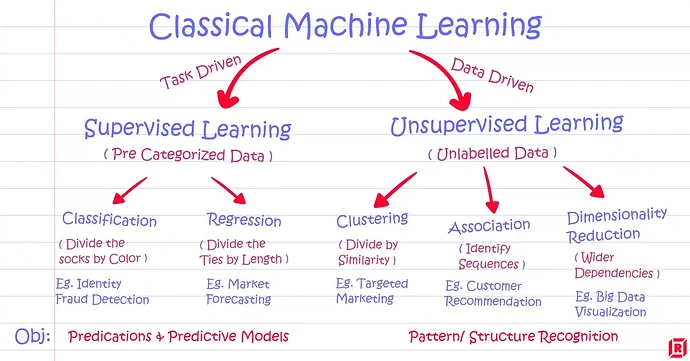

Học có giám sát so với học không giám sát

Hãy thảo luận về quá trình huấn luyện. Chữ P trong GPT là viết tắt của “pre-trained” (được huấn luyện trước), và đó là một phần quan trọng để hiểu tại sao GPT có khả năng thực hiện những gì nó có thể làm.

Trước GPT, những mô hình AI hoạt động tốt nhất sử dụng “học có giám sát” để phát triển thuật toán cơ bản của họ. Chúng được huấn luyện với dữ liệu đã được gắn nhãn một cách thủ công, giống như một cơ sở dữ liệu với các bức ảnh của các loài động vật khác nhau đi kèm với mô tả văn bản của mỗi loài động vật được viết bởi con người (đánh nhãn). Những loại dữ liệu huấn luyện này, mặc dù hiệu quả trong một số trường hợp, là rất đắt đỏ để sản xuất. Ngay cả bây giờ, chỉ có một lượng dữ liệu nhỏ được gắn nhãn và phân loại phù hợp để huấn luyện LLMs.

Thay vào đó, GPT sử dụng phương pháp huấn luyện sinh thái, nơi nó được đặt ra một số quy tắc cơ bản và sau đó được cấp dữ liệu không gắn nhãn một cách lớn hơn nhiều và gần như toàn bộ thông tin kết nối với internet. Sau đó, nó được học “không giám sát” để xử lý tất cả dữ liệu này và phát triển sự hiểu biết của riêng mình về các quy tắc và mối quan hệ điều khiển văn bản.

Tất nhiên, bạn thực sự không biết bạn sẽ nhận được gì khi sử dụng học không giám sát, vì vậy GPT cũng được “tinh chỉnh” để làm cho hành vi của nó có thể dự đoán được và thích hợp hơn. Có một số cách thực hiện điều này (mà tôi sẽ đề cập), nhưng thường sử dụng các hình thức của học có giám sát.

Kiến trúc Transformer

Tất cả những việc huấn luyện này nhằm tạo ra một mạng nơ-ron học sâu - một thuật toán phức tạp, đa tầng, có trọng số được mô phỏng theo bộ não con người - điều này cho phép ChatGPT học được các mẫu và mối quan hệ trong dữ liệu văn bản và khai thác khả năng tạo ra các phản ứng giống con người bằng cách dự đoán văn bản nào nên xuất hiện tiếp theo trong bất kỳ câu nào.

Mạng này sử dụng một thứ gọi là kiến trúc transformer (chữ T trong GPT) và đã được đề xuất trong một bài nghiên cứu vào năm 2017. Nó hoàn toàn quan trọng đối với sự bùng nổ hiện tại của các mô hình AI.

Mặc dù nó nghe và thực sự phức tạp khi bạn giải thích, mô hình transformer đã đơn giản hóa cách thiết kế thuật toán AI. Nó cho phép các phép tính được song song hóa (hoặc được thực hiện cùng một lúc), điều này có nghĩa là thời gian huấn luyện giảm đáng kể. Nó không chỉ làm cho các mô hình AI tốt hơn mà còn làm cho chúng nhanh và rẻ hơn để sản xuất.

Ở trung tâm của transformers là một quá trình gọi là “tự chú ý - self-attention”. Các mạng nơ-ron phản hồi cũ (RNNs) đọc văn bản từ trái sang phải. Điều này hoàn toàn ổn khi các từ và khái niệm liên quan đến nhau, nhưng nó tạo ra sự phức tạp khi chúng ở hai đầu của câu. (Đây cũng là một cách tính toán khá chậm vì nó phải được thực hiện tuần tự.)

Tuy nhiên, transformers đọc mỗi từ trong một câu cùng một lúc và so sánh từng từ với tất cả các từ khác. Điều này cho phép chúng hướng “sự chú ý” của mình đến các từ liên quan nhất, không phụ thuộc vào chúng ở đâu trong câu. Và nó có thể được thực hiện song song trên phần cứng tính toán hiện đại.

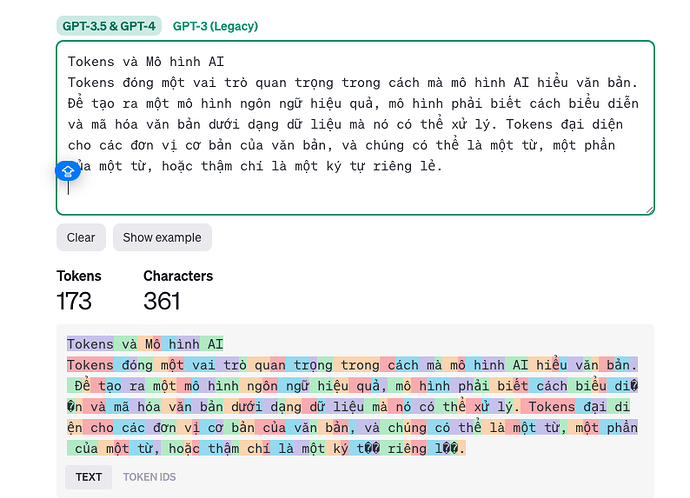

Tất nhiên, tất cả những điều này đều đơn giản hóa mọi thứ. Transformers không làm việc với từ, chúng làm việc với “token”, là các phần văn bản được mã hóa dưới dạng vector (một số có vị trí và hướng). Càng gần hai token-vector trong không gian, chúng càng liên quan đến nhau. Tương tự, sự chú ý được mã hóa dưới dạng vector, cho phép mạng nơ-ron dựa trên transformer nhớ thông tin quan trọng từ trước trong một đoạn văn.

Và đó là trước khi chúng ta thậm chí bắt đầu nói về toán học cơ bản của cách nó hoạt động. Mặc dù nó vượt ra ngoài phạm vi của bài viết này để đề cập đến nó, nhưng Machine Learning Mastery có một số giải thích chuyên sâu về khía cạnh kỹ thuật của vấn đề.

Tokens và Mô hình AI

Tokens đóng một vai trò quan trọng trong cách mà mô hình AI hiểu văn bản. Để tạo ra một mô hình ngôn ngữ hiệu quả, mô hình phải biết cách biểu diễn và mã hóa văn bản dưới dạng dữ liệu mà nó có thể xử lý. Tokens đại diện cho các đơn vị cơ bản của văn bản, và chúng có thể là một từ, một phần của một từ, hoặc thậm chí là một ký tự riêng lẻ.

GPT-3 đã được huấn luyện trên khoảng 500 tỷ tokens, điều này giúp mô hình ngôn ngữ của nó dễ dàng gán nghĩa và dự đoán văn bản tiếp theo một cách hợp lý bằng cách ánh xạ chúng trong không gian vector. Nhiều từ được ánh xạ thành một token duy nhất, mặc dù các từ dài hơn hoặc phức tạp hơn thường được chia thành nhiều tokens. Trung bình, mỗi token có khoảng bốn ký tự(Eng). OpenAI chưa tiết lộ chi tiết về cách hoạt động bên trong của GPT-4, nhưng chúng ta có thể chắc chắn rằng nó đã được huấn luyện trên một bộ dữ liệu tương tự vì nó còn mạnh mẽ hơn.

Tất cả các tokens đều được lấy từ một bộ dữ liệu lớn được viết bởi con người. Điều này bao gồm sách, bài viết và các tài liệu khác trên tất cả các chủ đề, phong cách và thể loại khác nhau - và một lượng nội dung khó tin được thu thập từ việc truy cập internet. Cơ bản, nó đã được cho phép xử lý tổng cộng rất nhiều kiến thức đa dạng của loài người để phát triển mạng lưới mà nó sử dụng cho việc tạo ra văn bản.

Dựa trên tất cả những việc huấn luyện đó, mạng nơ-ron của GPT-3 có 175 tỷ tham số hoặc biến cho phép nó lấy một input - lời nhắc của bạn - và sau đó, dựa trên các giá trị và trọng số mà nó gán cho các tham số khác nhau (và một lượng nhỏ ngẫu nhiên), xuất ra bất cứ điều gì nó nghĩ rằng phù hợp nhất với yêu cầu của bạn. OpenAI chưa nói rõ GPT-4 có bao nhiêu tham số, nhưng đó là một dự đoán an toàn rằng nó nhiều hơn 175 tỷ và ít hơn con số từng được đồn đoán là 100 nghìn tỷ tham số. Bất kể con số chính xác là bao nhiêu, nhiều tham số hơn không hoàn toàn đồng nghĩa là nó tốt hơn. Một phần sức mạnh tăng lên của GPT-4 có lẽ đến từ việc có nhiều tham số hơn GPT-3, nhưng nhiều khả năng do việc cải tiến cách nó được huấn luyện.

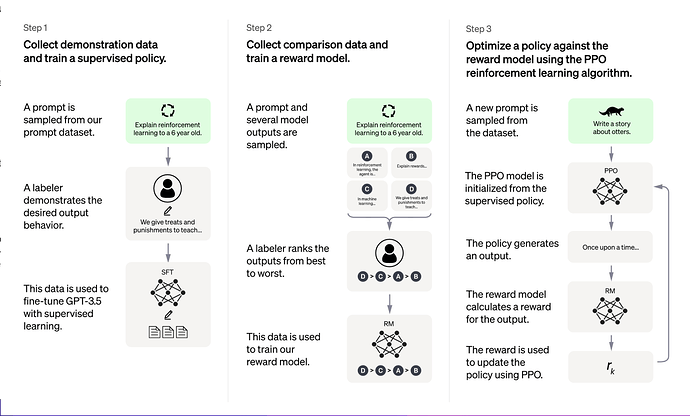

Học tăng cường từ phản hồi của con người (RLHF Reinforcement learning from human feedback)

Tất nhiên, mạng nơ-ron ban đầu của GPT hoàn toàn không phù hợp để phát hành công khai. Rốt cuộc, nó đã được đào tạo trên internet mở với gần như không có sự hướng dẫn. Vì vậy, để tinh chỉnh khả năng phản hồi của ChatGPT trước một loạt các lời nhắc khác nhau một cách an toàn, hợp lý và mạch lạc, nó đã được tối ưu hóa cho cuộc đối thoại bằng một kỹ thuật gọi là học tăng cường từ phản hồi của con người (RLHF).

Cơ bản, OpenAI đã tạo ra một số dữ liệu minh họa cho thấy mạng nơ-ron nên phản hồi như thế nào trong các tình huống điển hình. Từ đó, họ tạo ra một mô hình phần thưởng với dữ liệu so sánh (nơi hai hoặc nhiều hơn các phản hồi của mô hình được xếp hạng bởi người đào tạo AI), vì vậy AI có thể học được phản hồi nào là tốt nhất trong bất kỳ tình huống nào. Mặc dù không phải là học giám sát thuần túy, RLHF cho phép các mạng lưới giống như GPT được tinh chỉnh một cách hiệu quả.

Xử lý ngôn ngữ tự nhiên (NLP)

Tất cả những nỗ lực này nhằm làm cho GPT hiệu quả nhất có thể trong việc xử lý ngôn ngữ tự nhiên (NLP). NLP là một danh mục rất lớn bao gồm nhiều khía cạnh của trí tuệ nhân tạo, bao gồm nhận dạng giọng nói, dịch máy và chatbot, nhưng nó có thể được hiểu là quá trình thông qua đó Al được dạy để hiểu quy tắc và cú pháp của ngôn ngữ, được lập trình để phát triển các thuật toán phức tạp để biểu diễn những quy tắc đó và sau đó sử dụng những thuật toán đó để thực hiện các nhiệm vụ cụ thể.

Vì tôi đã nói về phần đào tạo và phát triển thuật toán, hãy xem cách NLP cho phép GPT thực hiện các nhiệm vụ cụ thể - cụ thể là phản hồi cho các lời nhắc của người dùng.

Quan trọng là phải hiểu rằng dù đã thảo luận về tokens, ChatGPT đang tạo ra văn bản về những từ, câu và thậm chí đoạn văn nào đó. Đây không phải là văn bản dự đoán trên điện thoại của bạn một cách thô bạo như việc đoán từ tiếp theo; nó đang cố gắng tạo ra các phản hồi hoàn toàn mạch lạc cho bất kỳ lời nhắc nào (prompts). Đây là những gì các biến đổi mang lại cho NLP.

Cuối cùng, cách đơn giản nhất để tưởng tượng nó giống như một trong những trò chơi “hoàn thành câu” bạn đã chơi khi còn nhỏ.

ChatGPT bắt đầu bằng cách lấy lời nhắc (prompts) của bạn, chia nó thành các token và sau đó sử dụng mạng nơ-ron dựa trên biến đổi của mình để cố gắng hiểu phần nào của nó là quan trọng nhất và bạn thực sự muốn nó làm gì. Từ đó, mạng nơ-ron hoạt động lại và tạo ra một chuỗi token phản hồi phù hợp, dựa vào những gì nó học được từ dữ liệu đào tạo và tinh chỉnh.

Ví dụ, khi tôi đưa cho ChatGPT sử dụng GPT-3 lời nhắc, “Zapier là…” nó đã phản hồi rằng:

“Zapier là một công cụ tự động hóa dựa trên web cho phép người dùng kết nối các ứng dụng web khác nhau với nhau để tự động hóa các công việc lặp đi lặp lại và cải thiện quy trình làm việc.”

Đó là loại câu bạn có thể tìm thấy trong hàng trăm bài viết mô tả về những gì Zapier làm, vì vậy nó có lý khi nó xuất hiện ở đây. Nhưng khi biên tập viên của tôi đưa ra lời nhắc giống như vậy, nó nói:

“Zapier là một công cụ tự động hóa dựa trên web cho phép người dùng kết nối các ứng dụng web khác nhau và tự động hóa quy trình làm việc giữa chúng.”

Đó khá giống nhau, nhưng đó không phải là cùng một phản hồi. Hỏi “Zapier là gì?”, “Zapier làm gì?” và “Mô tả Zapier” cũng đều cho kết quả tương tự, có lẽ vì chúng có vị trí tương tự trong không gian vector. GPT hiểu rằng từ quan trọng nhất ở đây là Zapier, và tất cả các từ khác chỉ đơn giản là yêu cầu một bản tóm tắt ngắn trong các cách khác nhau.

Sự ngẫu nhiên đó (mà bạn có thể kiểm soát trong một số ứng dụng GPT với một cài đặt có tên “temperature”) đảm bảo rằng ChatGPT không chỉ phản hồi mỗi câu trả lời với những gì giống như một câu trả lời tiêu chuẩn theo mẫu. Nó chạy mỗi lời nhắc qua toàn bộ mạng nơ-ron mỗi lần và tung xúc xắc ở đây và đó để giữ mọi thứ mới mẻ không lặp lại. Sự hiểu biết về ngôn ngữ tự nhiên cũng cho phép nó phân tích sự khác biệt tinh tế giữa “Zapier là gì?” và “Zapier làm gì?” Mặc dù là những câu hỏi tương tự, bạn sẽ mong đợi câu trả lời sẽ hơi khác nhau. Dù bạn hỏi theo cách nào, ChatGPT không có khả năng bắt đầu tuyên bố rằng Zapier là một màu sắc từ sao Hỏa, nhưng nó sẽ trộn lẫn các từ tiếp theo dựa trên xác suất tương đối của chúng.

Đưa ra lời văn, không phải kiến thức

Dù tôi nói nhiều về “hiểu” và “nhận biết,” bạn cần nhớ rằng những từ này chỉ đơn giản là những từ hữu ích nhất chúng ta có để mô tả cách trí tuệ nhân tạo hoạt động. GPT thực sự không hiểu tiếng Anh, nhưng nó có một bản đồ chi tiết về cách nhiều khái niệm liên quan đến nhau. Những người sáng tạo ChatGPT đầu tiên nói rằng nó có thể tạo ra thông tin không chính xác (và có thể gây hại), mặc dù họ đang nỗ lực khắc phục.

Dưới đây là một ví dụ nhẹ nhàng. Khi tôi hỏi ChatGPT sử dụng GPT-3 và GPT-4 để trả lời “Harry Guinness là…”, GPT-3 trả lời đầu tiên bằng cách hỏi Harry Guinness nào. Câu hỏi tuyệt vời — có đúng hai người như vậy! Vì vậy, tôi nói, “Harry Guinness là người viết” (đó là tôi). GPT-4 đoán ngay lập tức tôi là ai, mặc dù cả hai phản hồi đều thú vị:

-

GPT-3: Harry Guinness là một nhà văn tự do và nhà báo tại Ireland. Anh ấy đã viết cho nhiều ấn phẩm, bao gồm The New York Times, The Guardian, The Huffington Post và Popular Mechanics. Anh ấy viết về nhiều chủ đề từ công nghệ và nhiếp ảnh đến du lịch và văn hóa.

-

GPT-4: Harry Guinness là một nhà văn, nhiếp ảnh gia và chuyên gia công nghệ người Ireland. Anh đã viết cho các ấn phẩm khác nhau, bao gồm How-To Geek, Lifehacker và Tuts+. Công việc của anh chủ yếu tập trung vào công nghệ, hướng dẫn và mẹo, cũng như nhiếp ảnh và chỉnh sửa hình ảnh. Guinness đã xây dựng danh tiếng cho việc tạo ra các hướng dẫn chi tiết giúp đọc giả hiểu về các chủ đề phức tạp hoặc giải quyết vấn đề một cách trực tiếp.

Dòng đầu tiên và dòng cuối của GPT-3 được lấy gần như đúng từ các trang web và tiểu sử tác giả của tôi trên mạng (mặc dù tôi thường tự cho mình là một nhà văn tự do và nhiếp ảnh gia, không phải nhà báo). Nhưng danh sách các ấn phẩm gần như được tạo ra. Tôi đã viết cho The New York Times, nhưng không phải cho The Guardian, The Huffington Post, hay Popular Mechanics (Tôi thường xuyên viết cho Popular Science, vì vậy có thể đó là nơi nó xuất phát).

GPT-4 đã nắm bắt đúng phần nhiếp ảnh và thực sự liệt kê một số ấn phẩm mà tôi đã viết, điều này rất ấn tượng, mặc dù chúng không phải là những ấn phẩm tôi tự hào nhất. Đây là một ví dụ tuyệt vời về cách OpenAI đã tăng độ chính xác của GPT-4 so với GPT-3, mặc dù nó có thể không luôn cung cấp câu trả lời chính xác nhất.

Nhưng hãy trở lại GPT-3 vì lỗi của nó cung cấp một ví dụ thú vị về những gì đang xảy ra đằng sau hậu trường của ChatGPT. Nó thực sự không biết gì về tôi. Nó thậm chí không sao chép/dán từ internet và tin tưởng nguồn thông tin. Thay vào đó, nó chỉ dự đoán một chuỗi từ sẽ xuất hiện tiếp theo dựa trên hàng tỷ điểm dữ liệu mà nó có.

Ví dụ: The New York Times thường được nhóm với The Guardian và The Huffington Post hơn là với những nơi tôi đã viết, như Wired, Outside, The Irish Times và, tất nhiên, Zapier. Vì vậy, khi nó phải xác định những gì nên tiếp theo sau The New York Times, nó không lấy từ thông tin đã xuất bản về tôi; nó lấy danh sách các ấn phẩm lớn từ tất cả dữ liệu đào tạo mà nó có (hoặc thực sự, xem xét nơi chúng được ánh xạ trong không gian vector). Nó rất thông minh và trông có vẻ hợp lý, nhưng điều đó không phải là sự thật.

GPT-4 làm tốt hơn nhiều và xác định chính xác các ấn phẩm, nhưng phần còn lại của những gì nó nói thực sự chỉ cảm giác như những câu văn tiếp theo hợp lý. Tôi không nghĩ rằng nó có bất kỳ sự đánh giá cao nào cho danh tiếng của tôi: nó chỉ nói những thứ mà một tiểu sử thường nói. Nó giỏi hơn nhiều trong việc che giấu cách nó hoạt động so với GPT-3, mặc dù thực ra nó sử dụng cùng một kỹ thuật.

Dù sao, thật ấn tượng về mức độ GPT đã cải thiện đến thế nào. Hiện tại, GPT-4 đang giới hạn ở mức độ nhất định cho nên hầu hết nội dung ChatGPT bạn thấy sẽ dựa vào GPT-3, nhưng điều đó có thể thay đổi trong thời gian tới. Ai biết ở thế hệ tiếp theo như GPT-5 sẽ mang lại cho chúng ta điều gì.

Bài viết được dịch và biên soạn lại bởi GPT - nguồn zapier.com